19. Aug. 2025

3rd World Conference on eXplainable AI

XITASOs Beitrag zu verantwortungsvoller und transparenter KI

Vom 9. bis 11. Juli hatten wir die Gelegenheit, an der XAI25 in Istanbul teilzunehmen. Diese Veranstaltung brachte renommierte Expert*innen zusammen, um aktuelle KI-Trends zu diskutieren und ihre Forschungsergebnisse zu präsentieren. Unsere XITASOnians Anton Hummel und Emily Schiller haben an der Konferenz teilgenommen, ihre Forschungsagenda vorgestellt und an Diskussionen rund um die Themen vertrauenswürdige, transparente und zuverlässige KI teilgenommen.

Das Forschungsfeld eXplainable AI (XAI) zielt darauf ab, die Entscheidungsprozesse von KI-Modellen verständlich und nachvollziehbar zu machen. Mehr Details finden Sie in unserer Präsentation zu Explainable AI und Uncertainty Quantification. Neben zahlreichen, inspirierenden Sessions zu aktuellen Forschungstrends rund um XAI, haben besonders die Podiumsdiskussionen zur Integration von XAI in Industrieprozesse und dem Impact von XAI einen bleibenden Eindruck hinterlassen. Die wichtigsten Erkenntnisse haben wir im Folgenden zusammengefasst.

Herausforderungen für verantwortungsvolle KI in der Industrie

Ein zentrales Thema ist die Notwendigkeit, XAI in die Industrie zu integrieren, um den vollen Wert aus KI-Anwendungen zu schöpfen. Es wurde betont, dass XAI-Forschung über das Schreiben von Fachartikeln hinausgehen muss. Die Entwicklung von neuen Methoden sollte Hand in Hand mit der Veröffentlichung hochwertiger Softwarepakete einhergehen, um die Methoden in der Praxis und Industrie wirklich nutzbar zu machen. Die Zusammenarbeit zwischen Industrie und Forschung ist entscheidend. Unsere industrienahe Forschung bei XITASO hilft, diese Grenzen von Forschung und Industrie zu überwinden.

Von Erklärungen zu echtem Impact

XAI hat bereits zahlreiche, erfolgreiche Anwendungen gefunden, wie beispielsweise in der Medikamentenentwicklung und Radiologie. XAI kann helfen, Schwächen in Modellen zu identifizieren, deren Leistung zu verbessern oder KI-Prognosen für den Menschen nachvollziehbar zu machen. Oft ist die Forschung jedoch nicht mit den spezifischen Anforderungen der Praxis konfrontiert. Die Herausforderung besteht darin, XAI für konkrete Anwendungsfälle zu entwickeln und anzuwenden. Dafür werden Benchmarks und frei verfügbare Datensätze, sowie eine intensive Auseinandersetzung mit Stakeholdern benötigt, um die Forschung voranzutreiben und einen echten Mehrwert durch XAI zu schaffen.

Unser Beitrag zum Doctoral Consortium

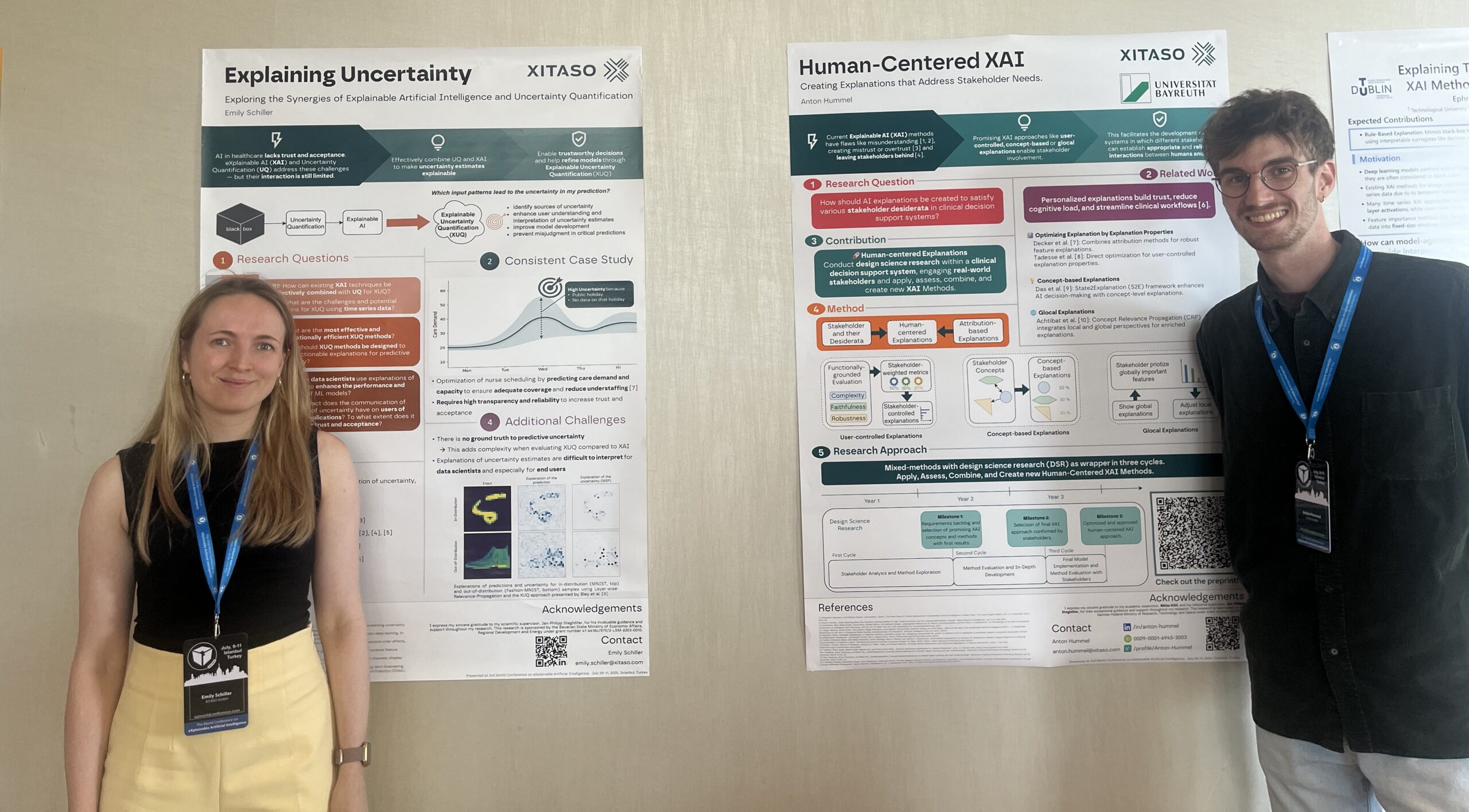

Am letzten Tag durften unsere Researcher Anton und Emily ihre Forschungsagenda im Doctoral Consortium der Konferenz präsentierten. Neben Präsentationen der individuellen Forschungsthemen, beinhaltete das Doctoral Consortium Mentoring-Sessions mit renommierten und erfahrenen Wissenschaftler*innen aus dem Forschungsfeld.

Human-Centered XAI

Antons Forschung (Paper) zielt darauf ab, Erklärungen zu entwickeln, die auf die individuellen Anforderungen verschiedener Stakeholder zugeschnitten sind und dadurch den Menschen im Fokus haben. Durch die Implementierung und iterative Bewertung von unterschiedlicher XAI-Methoden wie Concept-Based Explanations oder Glocal-Explanations sollen die individuellen Bedürfnisse der Nutzer adressiert werden. Antons Forschung liefert dafür einen entscheidenden Beitrag, um die Brücke zwischen Nutzenden und dem KI-System zu bauen. Dadurch soll die Forschung bei XITASO sowohl die Akzeptanz als auch das Vertrauen in KI-Systeme erhöhen und zu einer verantwortungsvolleren Anwendung von KI in unterschiedlichsten Anwendungen beitragen.

Erklärung von Vorhersageunsicherheiten

Emilys Forschung (Paper) konzentriert sich auf die Schnittstelle von XAI und Unsicherheitsquantifizierung, um zu erklären, wann und wieso KI-Modelle sich in Vorhersagen unsicher sind. Durch die Entwicklung effizienter Methoden zur Erklärung von Unsicherheitsabschätzungen in Gesundheitsanwendungen soll die Performance der KI-Modelle und deren Interpretierbarkeit gesteigert werden.

Die Kombination von Unsicherheitsquantifizierung und XAI ist besonders relevant, wenn Entscheidungen basierend auf KI-Vorhersagen mit Risiken verbunden sind. Das können sowohl monetäre Risiken, z.B. im Maschinenbau bei der Vorhersage von Produktionsfehlern, als auch sicherheitsbezogene Risiken sein, z.B. in der Medizintechnik bei der Vorhersage von Diagnosen. Darüber hinaus kann die Erklärung von Vorhersageunsicherheiten bei der Fehlersuche und Überwachung von KI-Modellen helfen, um die Zuverlässigkeit und Robustheit von Modellen zu steigern.

Auszeichnung für das beste Doctoral Proposal

Emilys Arbeit zur Erklärung von Unsicherheiten in KI-Vorhersagen wurde mit dem „Best Doctoral Proposal Award“ der Konferenz ausgezeichnet. Diese Anerkennung unterstreicht die Bedeutung und den innovativen Charakter unserer Forschung, die darauf abzielt, KI auch in sicherheitskritischen Bereichen in die Praxis zu bringen.

Abschließende Gedanken zur Konferenz

Die Konferenz hat gezeigt, dass XAI zunehmend in realen Szenarien, insbesondere in Hochrisikoanwendungen wie dem Gesundheitswesen, evaluiert werden muss. Hierbei spielt interdisziplinäre Forschung eine entscheidende Rolle. Um die Kluft zwischen Wissenschaft und Industrie zu überbrücken, benötigen wir XAI-Methoden, die einfach zu verwenden, zugänglich und anwendbar sind.

Die Teilnahme an der XAI25 war eine inspirierende Erfahrung, die uns wertvolle Einblicke in die Zukunft der KI und deren verantwortungsvolle Anwendung gegeben hat. Wir freuen uns darauf, diese Erkenntnisse in unsere Arbeit bei XITASO zu integrieren und weiterhin innovative Lösungen für unsere Kunden zu entwickeln.